课程介绍

Distributed Systems课程一共包含Lab1-4共4个大作业,Lab1是实现Mapreduce原型,Lab2-4是实现Raft以及基于Raft实现分布式KV存储。

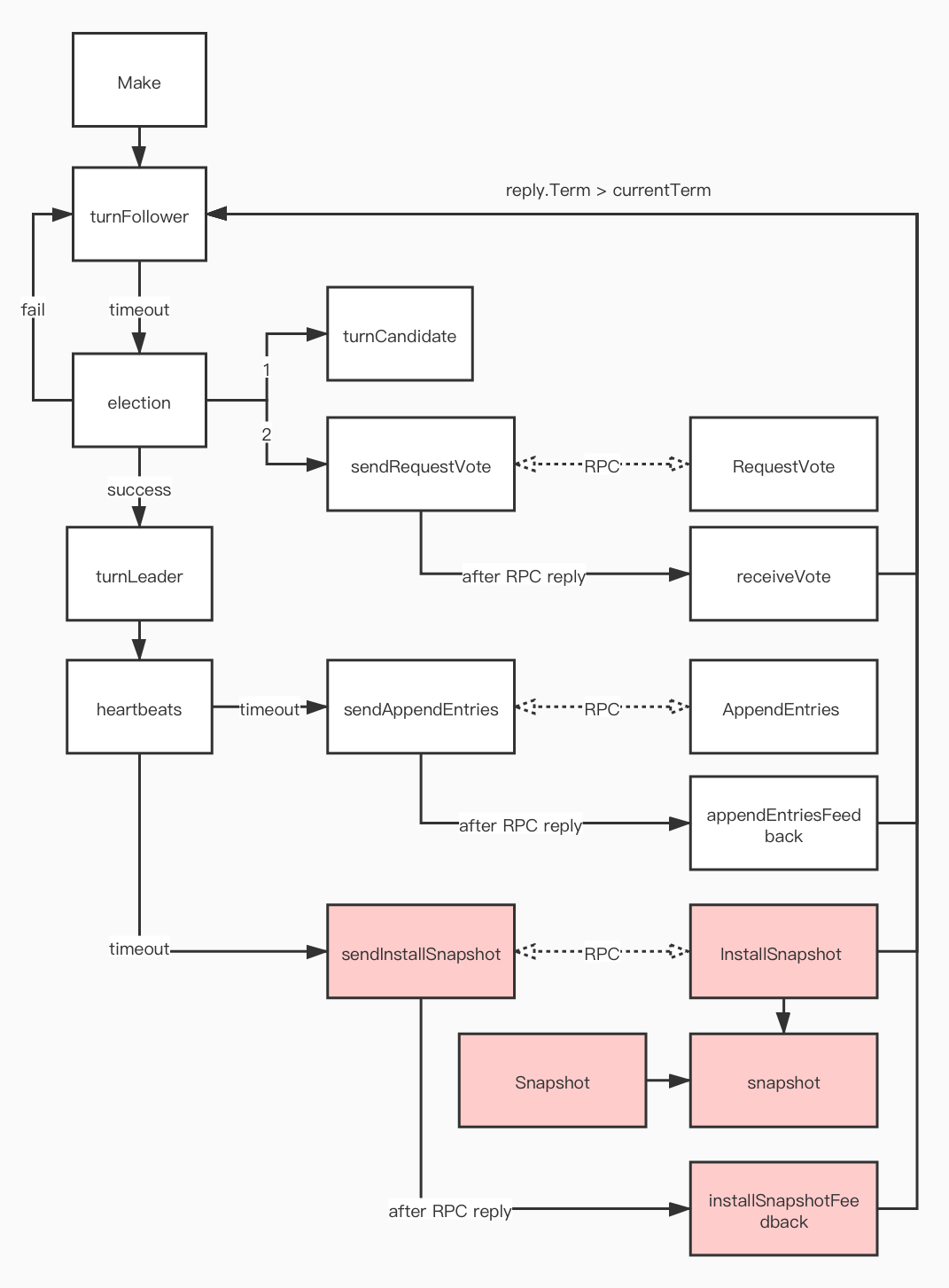

本次实现Raft,该实验(2020 年版本)分为三个部分,目标是开发一个容错的KV系统,分别是 Part 2A:leader 选举、Part 2B:日志同步、lab2C:状态备份。

实验要求

- key 和 value 都是字符串;

- 服务支持三种操作:

Put(key, value):替换key对应的value;Append(key, arg):将arg附加到key对应到value,如果不存在则等同于Put;Get(key):获取key对应的value,如果不存在返回空串;

- 执行一个操作前,需要确保之前都操作都已经落实了;

- 如果一个操作成功被应用,则通知客户端,否则向客户端报告一个错误,客户端应该重试其他服务器;

- 服务器之间不应该直接通信,只能通过 Raft 交换信息;

- 可以不实现论文 Section 8 中关于只读操作不写 log 的优化,把 Get 也写 log,最终收到 Raft apply 响应时说明已经取得了大多数,此时就避免了读脏数据的可能;

- 可以不实现服务器主动返回 leader,而在客户端对服务器遍历来寻找 leader;

- 可能出现这样的情况:当请求操作后,对应的服务器失去领导,新的 leader 接受了其他客户端的操作并提交,原来的服务器将新 leader 反馈的提交应用了,从而造成请求和响应不一致。可以在响应时判断服务器的任期是否变更,或者检查所响应的操作是否和请求对应上;

- 可以在客户端中记录最后通信的 leader,下次通信时优先考虑,从而节约寻找 leader 的时间;

- 当发生分区时,允许服务器和客户端无限期等待,直到分区恢复;

- Your scheme for duplicate detection should free server memory quickly, for example by having each RPC imply that the client has seen the reply for its previous RPC. It’s OK to assume that a client will make only one call into a Clerk at a time???

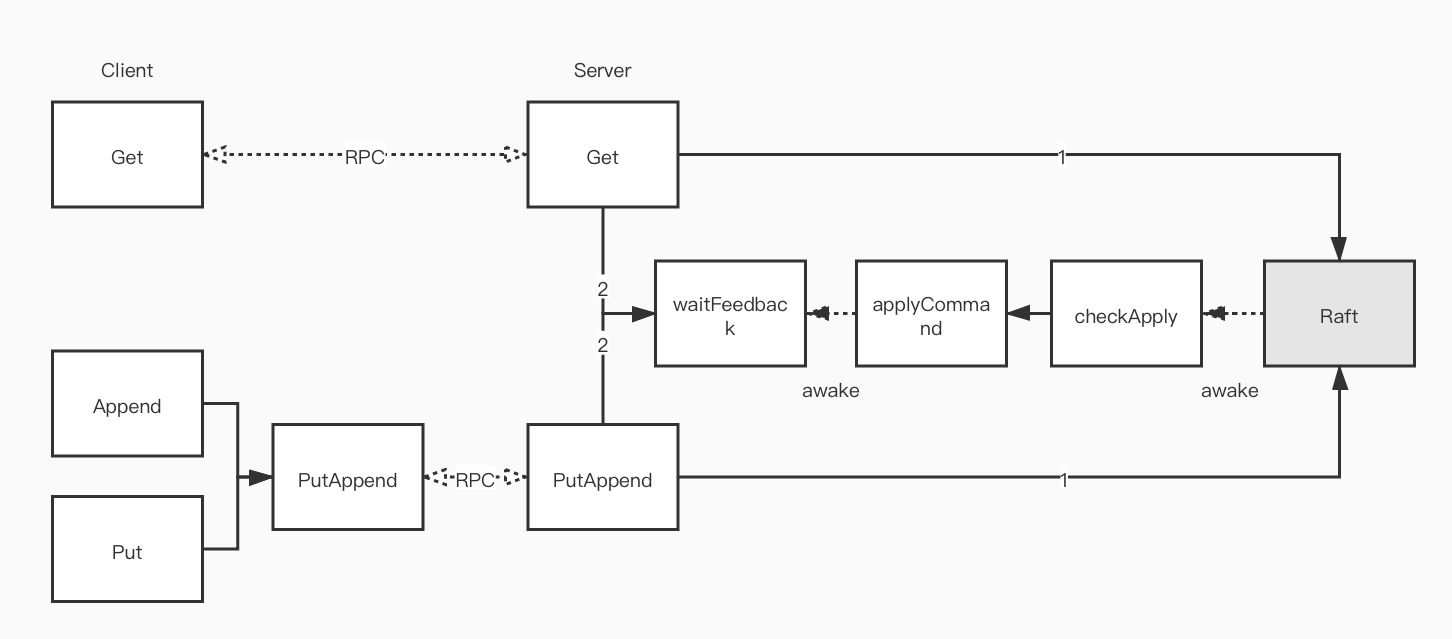

流程

实现细节

Client

避免同一个操作被执行多次的策略:为每个客户端设置一个唯一 Id,同时每个命令也有一个唯一 Id,由于单个客户端的请求是串行的,服务端只需要记录每个客户端最后执行的命令 Id 即可。设客户端数量为 $N$,服务器执行的总命令数量为 $M$,可知 $M \gg N$,采用这种策略可以将空间复杂度从 $O(M)$ 降为 $O(N)$

1 | func (ck *Clerk) Get(key string) string { |

Server

由于只有 Leader 会接受用户请求,而 Follower 也需要同步状态,所以对 Raft 返回的 Command 进行 apply 应该作为一个后台 goroutine 自动循环 apply

调用 Raft 接口的 goroutine[0] 不能有阻塞 apply goroutine[1] 的风险,这样会导致:goroutine[0] 等待 Raft 返回,Raft 等待 goroutine[1] 读取 channel,goroutine[1] 被 goroutine[0] 阻塞,最终死锁

1 | func (kv *KVServer) applyCommand(op Op) { |

Snapshot(Part B)

实验要求

maxraftstate为创建快照的 Raft 日志大小阈值,如果为 -1 则无需创建快照,通过persister.RaftStateSize()获取 Raft 日志大小;- K/V Server 通知 Raft 使用

persister.SaveStateAndSnapshot()同时保存 Raft 状态和快照,以使得日志的删除与快照的存储作为一个原子操作; - 使用

persister.ReadSnapshot()来读取最新的快照; - Your kvserver must be able to detect duplicated operations in the log across checkpoints, so any state you are using to detect them must be included in the snapshots.???

- 允许在单个 InstallSnapshot RPC 中发送整个快照代替论文中的分块发送;

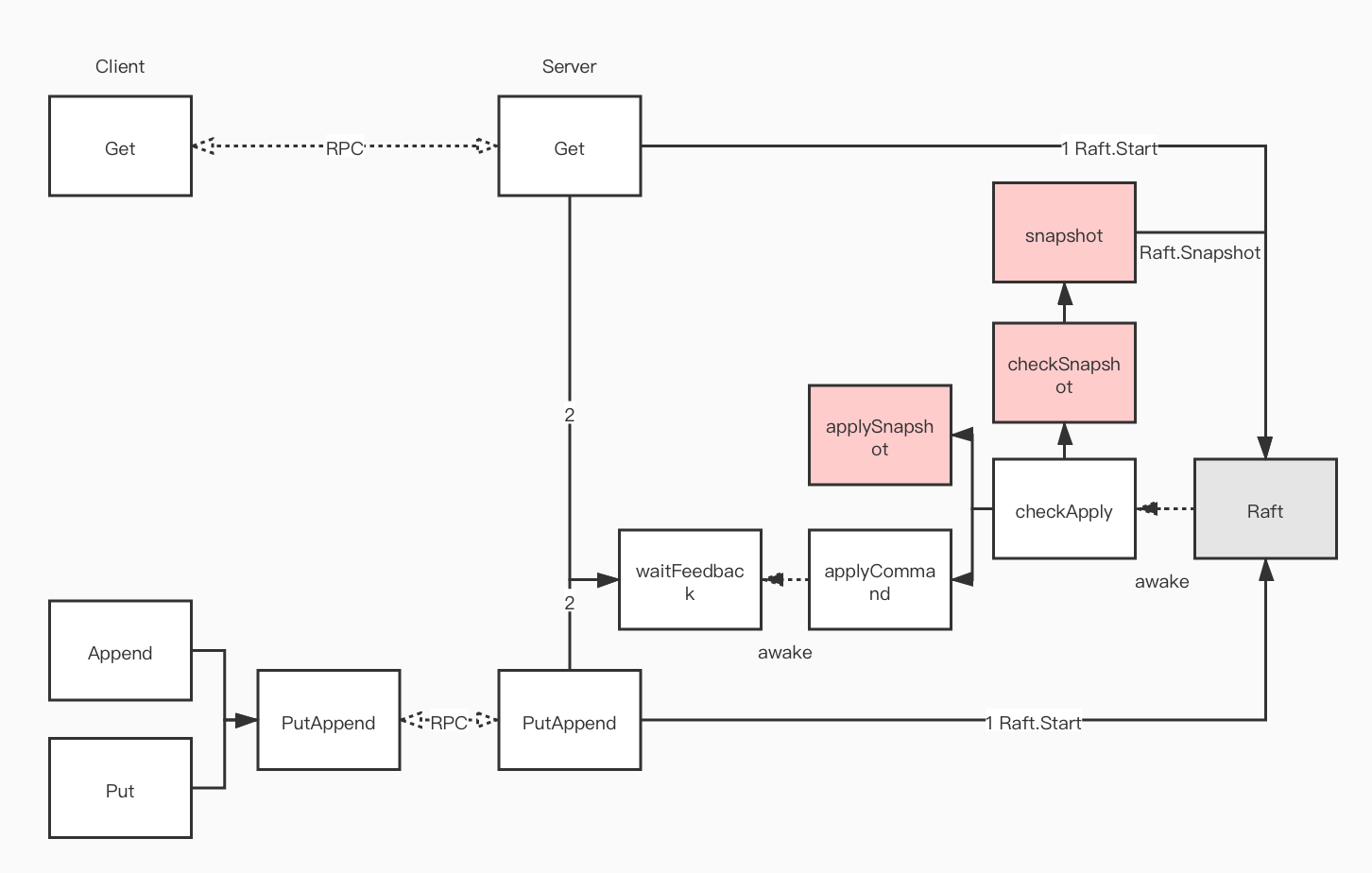

流程

实现细节

Server

检查 Raft 日志大小的时机应该是 apply Command 后,因为定时检查无法适应 Raft 日志增长速度,可能在两次检查间有大量 Raft 日志写入,而 apply Command 的速度与 Raft 日志的写入速度是相关的

为了防止阻塞 apply goroutine 造成死锁,不能在 apply goroutine 直接调用 Raft 接口进行 Snapshot,应该开启一个后台 snapshot goroutine 待命

1 | type KVServer struct { |

Raft

1 | func (rf *Raft) snapshot(lastIncludedIndex, lastIncludedTerm int, snapshot []byte) { |